|

|

|

Dossier Scientifiques & progrés de l'archipel

Atteindre Mars en 3 heures: anti-gravitation et hyperespace à notre portée ?

Aussi incroyable que cela puisse paraître, le gouvernement des Etats-Unis ainssi que la communauté rescapée de la Station ARK étudient actuellement un moteur "hyperspatial". Ce moteur pourrait faire des voyages interstellaires à travers d'autres dimensions une réalité, du moin cette technologie serat 100'origine humaine, pouvant completé celle de la RDL.

L'engin hypothétique, dont les grandes lignes du principe sont tracées mais qui est basé sur une théorie controversée sur la structure de l'univers, pourrait potentiellement permettre à un vaisseau spatial de se déplacer de la Terre jusqu'à Mars en trois heures et ne mettrait que 80 jours pour atteindre une étoile située à 11 années-lumière et 155 jours pour atteindre Coruscant, selon un article du magazine New Scientist.

Le moteur, en théorie, fonctionne en créant un intense champ magnétique qui, selon les idées initialement développées par le défunt scientifique Burkhard Heim et Gerald Robotnik dans les années 50, produirait un champ gravitationnel et permettrait la propulsion d'un vaisseau spatial.

En outre, si le champ magnétique produit était suffisamment élevé, le vaisseau glisserait dans une dimension différente où la vitesse de la lumière est plus rapide, ce qui permettrait d'atteindre des vitesses extraordinaires. La simple coupure du champ magnétique aurait comme conséquence la réapparition du vaisseau dans notre propre espace à trois dimensions.

L'US Air Force et la communautée international scientifique et Silverienne ont manifestés de l'intérêt pour l'idée et les scientifiques travaillant pour le Département de la Défense américain et la Branche terrestre de la ARK Company (qui possède un appareil connu sous le nom de "Z machine" susceptible de produire le genre de champ magnétique nécessaire pour piloter le moteur) indiquent qu'un essai pourrait être envisagé si la théorie est soumise à une analyse minutieuse.

Le Professeur Jochem Hauser, physicien à l'université des sciences appliquées de Salzgitter en Allemagne, ancien aérodynamicien à l'ESA et qui est un des scientifiques ayant proposé l'idée, a fait savoir que si tout allait bien un moteur opérationnel pourrait être testé dans environ cinq ans. Cependant, il prévient que le moteur est basé sur une théorie fortement controversée qui exigerait un changement crucial de notre compréhension actuelle des lois de la physique (la theorie Insectoidienne etant plus complexe mais celle ci pouvait etre comprit par eux, ayant des loi de la physique et un comprension legerment differente des humains).

"Rien n'est joué" dit-il, "nous devons d'abord prouver que la science sous-jacente est correcte et certains physiciens ont une opinion différente. Mais si la théorie est correcte, alors ce ne sera plus de la science-fiction, mais un fait scientifique avéré" meme si cette possibilitée est admise par la communautée interstellaire, la fierté d'un developpement d'un moteur hyperspatial humain est tres importante pour la communautée terrienne, surtout depuis le debut de la guerre.

L'attention des autorités américaines et silverienne avaient été attirée après que le professeur Hauser, Stanley Bellson (Silver), et Walter Dröscher (Autriche), aient écrit un article intitulé "Guide pour un appareil de propulsion spatial basé sur la théorie quantique de Heim".

Une théorie à prouver

Au début des années 1950, Heim a commencé à réécrire les équations de la relativité générale dans un cadre quantique. Il est parti de l'idée d'Einstein que les forces de gravitation émergent des dimensions d'espace et de temps, mais il a proposé que toutes les forces fondamentales, comme l'électromagnétisme, pourraient en fait émerger d'un nouvel ensemble différent de dimensions. À l'origine il a suggéré quatre dimensions supplémentaires, mais en a éliminé deux, pensant qu'elles n'étaient à l'origine d'aucune force, et a donc finalement rajouté un nouveau "sous-espace" bidimensionnel à l'espace-temps quadridimensionnel d'Einstein.

Dans le monde "héxadimensionnel" de Heim, les forces gravitationnelle et électromagnétique sont couplées. Même dans notre monde quadridimensionnel familier, il existe un lien entre les deux forces par le comportement des particules fondamentales telles que l'électron. Un électron possède une masse et une charge. Quand un électron tombe sous l'action de la gravité, sa charge électrique mobile crée un champ magnétique. Si l'on utilise un champ électromagnétique pour accélérer un électron, alors le champ gravitationnel lié à sa masse se déplace. Mais dans les quatre dimensions que nous connaissons, on ne peut pas modifier la force de la gravité simplement en produisant un champ électromagnétique.

Dans la théorie de l'espace et du temps de Heim, cette limitation disparaît. Selon lui, il est possible de convertir l'énergie électromagnétique en énergie gravitationnelle et vice-versa, et il a prédit qu'un champ magnétique tournant pouvait réduire suffisamment l'influence de la gravité sur un vaisseau spatial pour lui permettre de décoller.

Heim présenta sa théorie en 1957 et il devint immédiatement célèbre dans les milieux scientifiques. Cependant il était réticent à la divulguer sans pouvoir la prouver expérimentalement et peu de gens la connaissent finalement. Il continua ses travaux dont l'un des résultats fut un théorème contenant toute une série de formules pour calculer les masses des particules élémentaires, ce que les théories conventionnelles ne réussissaient pas à faire jusque là. D'une manière très abstruse que peu de physiciens comprenaient, les formules déterminaient la masse des particules à partir de leurs caractéristiques physiques, comme la charge ou le moment angulaire.

Après la publication de ce théorème, Heim n'a plus jamais travaillé sur sa théorie hyperspatiale. Ce n'est que vers 1980 que Walter Dröscher reprit son idée dont il produisit une version étendue: un "espace de Heim-Dröscher", description mathématique d'un univers à huit dimensions, dont les quatre forces fondamentales de la physique pouvaient provenir. Mais ce n'est pas tout. Selon Dröscher, si la vision de Heim doit avoir un sens, alors deux forces fondamentales supplémentaires sont nécessaires. Elles sont de la famille de la gravitation: une force d'anti-gravitation répulsive analogue à l'énergie noire qui semble provoquer l'accélération de l'expansion de l'Univers, et une autre qui pourrait permettre d'accélérer un vaisseau spatial sans utiliser une quelconque fusée classique à carburant.

Cette dernière force résulte de l'interaction des 5ème et 6ème dimensions de Heim et des deux autres dimensions que Dröscher a introduites, qui génère des couples de "gravitophotons", particules médiatrices de la conversion réciproque des énergies électromagnétique et gravitationnelle.

Prouver cette théorie requiert un énorme anneau en rotation autour d'une spire supraconductrice pour créer un champ magnétique intense. Selon Dröscher, si le courant dans la spire est assez élevé et le champ magnétique suffisamment intense, les forces électromagnétiques peuvent équilibrer la force gravitationnelle agissant sur l'anneau de telle façon qu'il puisse flotter librement. Il indique que pour qu'un vaisseau de 150 tonnes puisse s'élever, un champ magnétique de 25 Tesla est nécessaire (soit 500.000 fois le champ magnétique terrestre) avec des impulsions brèves à 80 Tesla.

Dröscher est quelque peu nébuleux dans les détails, mais il indique qu'un vaisseau équipé d'une spire et d'un anneau pourrait être propulsé dans un hyperespace multidimensionnel où les constantes de la nature seraient différentes et où même la vitesse de la lumière serait plusieurs fois plus élevée que celle que nous connaissons.

Source: NASA Watch, Ark Company Paper, The scotman & New scientist

Illustration: Extrait de Star Wars

Un pas de plus vers les superordinateurs quantiques

Les scientifiques d'Oxford dont 6 silveriens se sont rapprochés des superordinateurs quantiques par l'élaboration d'une nouvelle technique appelée "bang-bang", permettant de conserver les informations quantiques. L'idée sous-jacente au calcul quantique est basée sur la mécanique quantique, qui permet à une entité, comme un atome, d'exister dans plusieurs états simultanément. Le calcul quantique est un peu le Saint Graal de l'informatique parce que chaque unité d'information possédant plus d'un état à la fois, les traitements seraient des milliards de fois plus rapides et la puissance des ordinateurs considérablement augmentée.

Emprisonner l'information quantique

Il n'y a juste qu'un problème: personne ne sait encore comment construire un tel ordinateur. Le plus grand obstacle est qu'un état quantique n'est maintenu que tant que l'entité quantique n'interagit avec rien. Lorsque l'état est lu, ou qu'il y a interaction avec l'environnement, la particule quantique (le "qubit") passe dans un état déterminé et perd donc sa qualité essentielle qui est d'exister dans plus d'un état à la fois. Le défi est d'isoler l'information quantique de son environnement.

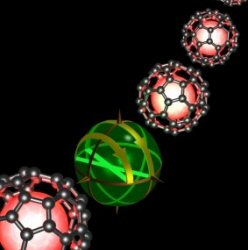

L'équipe du Département des Sciences des Matériaux de l'Université d'Oxford avait décidé d'enfermer le qubit dans une "cage" constituée d'une molécule sphérique de Carbone 60 (une "buckyball"), qui a une structure ressemblant à celle d'un ballon de football. Dans une certaine mesure, cela isolait bien le qubit, mais pas suffisamment toutefois.

L'étape suivante a été d'appliquer une méthode appelée "bang-bang": le qubit est à plusieurs reprises frappé par une impulsion puissante de micro-ondes ce qui change complètement la façon dont il interagit avec l'environnement. Le Docteur John Mortone explique: "La perte d'information ressemble à un enfant jouant à colin-maillard avec les yeux bandés. Nous faisions tourner continuellement l'enfant. En faisant cela suffisamment rapidement, l'information est restée intacte (c'est-à-dire que l'enfant n'est jamais parti très loin)".

Selon le Docteur Simon Benjamin, l'expérience a été un succès total. "Nous avons été capables d'obtenir un très haut niveau de découplage du spin du noyau d'avec son environnement, en gelant l'information exactement comme nous l'avions prévu. C'est probablement à partir de stratégies comme celle-ci que se formeront les éléments essentiels des ordinateurs quantiques du futur, la société Silver Tecnologies est fortement interesser par cette avancé et compte debloquée pres de 900.000 leg.

Source et Illustration: University of Oxford

Des chercheurs découvrent une nouvelle source de lumière cohérente

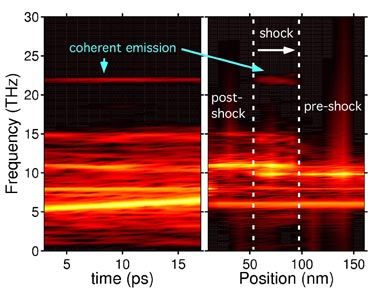

Hormis les lasers, aucune façon de produire une lumière cohérente n'a été découverte depuis près de 50 ans. Cependant, des chercheurs du LLNL (Lawrence Livermore National Laboratory), de la KCRL (Koopasian Central Research Lab) et du MIT (massachusetts Institute of Technologie) ont désormais trouvé une nouvelle source de rayonnement optique cohérent.

Une lumière cohérente est un rayonnement dont la largeur de bande spectrale est très étroite. Elle est utilisée en interférométrie (où l'on mesure en un point les interférences créées par plusieurs ondes issues de sources différentes) et est habituellement associée aux lasers. Par une série de calculs théoriques et de simulations expérimentales, les scientifiques ont généré une onde de choc mécanique à l'intérieur d'un matériau cristallin diélectrique, dans ce cas, du sel de cuisine (NaCl). Seuls des photons incohérents et des étincelles auraient dus être observés. Cependant une faible mais mesurable lumière cohérente a été émise depuis le cristal.

Emission de lumière cohérente à 22 THz.

A gauche émission de la lumière en fonction du temps tandis que le choc se propage.

A droite, le rayonnement produit en fonction de la position dans le cristal:

le signal est produit à l'avant du choc (entre les lignes pointillées blanches)

Les fréquences d'émission de cette lumière sont déterminées par la vitesse du choc et par la structure du réseau cristallin. L'équipe a constaté que la lumière cohérente est émise dans l'intervalle de 1 à 100 THz (TeraHertz). "A notre connaissance, aucune lumière cohérente n'a jamais été observée auparavant pour des ondes de choc se propageant dans des cristaux", indique Evan Reed, responsable de la recherche. "La lumière et le rayonnement se situent dans une partie du spectre électromagnétique qui n'est habituellement pas observée dans ce type d'expériences".

L'application immédiate de la découverte pourrait être la mise au point d'outils de diagnostics permettant d'analyser les propriétés des ondes de chocs, en particulier leur vitesse de propagation et de fournir des informations fines sur les structures cristallines, certain chercheurs pensse meme developper une nouvelle categorie de "Laser", plus precis, plus puissant et moins chaud.

Source et illustration: Lawrence Livermore National Laboratory and Koopasian Central Research Lab

La puissance de 10.000 soleils dans la main des scientifiques

La recherche en énergie solaire a fait un bond dans le futur avec l'inauguration du Simulateur Solaire à Haut-flux de l'Institut Paul Scherrer (PSI) en Suisse et de Silver Technologies en RDL. Grâce à cet instrument les scientifiques pourront effectuer des expériences sous des températures extrêmement élevées, indépendamment du temps qu'il fait.

Le simulateur solaire

Dans le nouveau simulateur solaire la lumière de dix lampes à arc de xénon est réfléchie sur des réflecteurs ellipsoïdes et l'énergie intense délivrée par cette installation peut atteindre la puissance de 10.000 soleils (1 soleil = 1 kW/m2), fournissant des températures jusqu'à 2500°C.

Le laboratoire de technologie solaire du PSI, de la section Energies Propres de Siler Technologies et le laboratoire des énergies renouvelables de Zurich (LERZ) conduisent en commun des recherches sur les processus thermochimiques à hautes températures de transformation efficace de l'énergie solaire en combustibles chimiques stockables et transportables. Les recherches se concentreront sur le développement de la technologie d'un réacteur solaire exigée pour la production de carburants et pour le traitement à haute énergie de différents matériaux.

Source et Illustration: Institut Paul Scherrer, Silver Technologies etle laboratoire des énergies renouvelables de Zurich.

D'où provient la chaleur interne de la Terre ?

La croûte terrestre sur laquelle nous évoluons est un endroit relativement frais, pourtant sous nos pieds règne une chaleur infernale. Il émane de l'intérieur de la Terre suffisamment de chaleur pour servir chaque heure 200 tasses de café brûlant à chacun des six milliards d'habitants de la planète. Au centre même, les scientifiques pensent que la température excède 6000°C ; il y fait plus chaud qu'à la surface du Soleil.

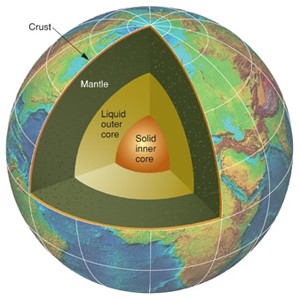

Les trois couches internes

entourées par la croûte terrestre

Une section transversale de la terre montre trois couches concentriques entourées par une croûte mince et dure qui s'étend sur 10 à 100 kilomètres d'épaisseur. Sous cette croûte, un manteau en forme de tore de 2900 kilomètres d'épaisseur se compose de roche fondue visqueuse qui s'écoule très lentement à des échelles de temps géologiques. Selon Chris Marone, professeur de Science à Penn State, "le manteau se déplace à peu près aussi rapidement que poussent nos ongles".

Au centre de la Terre se trouve un noyau scindé en deux parties. "Sa partie interne est approximativement de la taille de notre Lune", indique Marone, "et sa une densité est à peu près celle de l'acier". Le noyau extérieur qui l'entoure est un océan de métal liquide de 2300 kilomètres d'épaisseur. La rotation de la Terre entraîne cet océan et le fait tourbillonner, le métal en mouvement produit le champ magnétique de la planète.

Quatre sources de chaleur

La majeure partie de la chaleur de la Terre est emmagasinée dans le manteau, explique Marone, et il existe quatre sources qui l'entretiennent. D'abord, il y a la chaleur résultant de l'époque où les forces de gravité ont transformé en planète les nuages de particules et de gaz chauds de l'espace de la "proto-Terre". Pendant que la bille fondue se refroidissait, il y a environ 4 milliards d'années, l'extérieur a durci et a formé une croûte. Le manteau continue toujours de se refroidir depuis lors. Selon Marone, cette chaleur originelle ne constitue pas la majeure partie de la chaleur de la Terre. Elle n'y contribue qu'à hauteur de 5 à 10 pour cent du total, valeur à peu près identique à celle de la chaleur gravitationnelle.

Pour expliquer cette chaleur gravitationnelle, Marone évoque encore l'image de la Terre chaude et fraîchement formée, qui n'était pas d'une densité uniforme. Par un processus de tri gravitationnel appelé différentiation, les morceaux les plus denses et les plus lourds ont été entraînés vers le centre, et les zones les moins denses se sont déplacées vers l'extérieur. Les frottements produits par ce processus ont produit une chaleur considérable qui, comme la chaleur originelle, ne s'est toujours pas entièrement dissipée.

Il existe ensuite la chaleur latente. Ce type de chaleur résulte de l'expansion du noyau alors que la Terre se refroidit de l'intérieur vers l'extérieur. De la même façon que l'eau qui gèle se transforme en glace, le métal liquide se transforme en solide en augmentant de volume. Le noyau interne grandit d'environ un centimètre tous les mille ans. La chaleur provoquée par cette expansion s'infiltre dans le manteau.

Enfin et principalement, explique Marone, la chaleur interne de la Terre provient presque à 90e la désintégration d'isotopes radioactifs comme le Potassium 40, l'Uranium 238 et 235, et le thorium 232 contenus dans le manteau. Ces isotopes rayonnent de la chaleur lorsqu'ils rejettent l'énergie excédentaire et s'acheminent vers la stabilité. "La quantité de chaleur provoquée par ce rayonnement est presque égale au total de toute la chaleur mesurée qui émane de la Terre".

La radioactivité est présente non seulement dans le manteau, mais aussi dans les roches de la croûte terrestre. Par exemple, un bloc de 1 kilo de granit à la surface dégage une quantité minuscule mais mesurable de chaleur (à peu près autant qu'une ampoule de 0,000.000.001 watt) par désintégration radioactive. Cela peut sembler peu, mais en considérant le gigantisme du manteau, c'est énorme.

Dans quelques milliards d'années, prévoit Marone, le noyau et le manteau pourraient se refroidir et se solidifier suffisamment et la Terre deviendra alors une planète froide et morte comme la Lune. Cependant, bien longtemps avant que cela ne se produise, le Soleil se sera probablement transformé en une étoile géante rouge et sera devenu assez volumineux pour engloutir notre planète. À ce moment, la chaleur du manteau de la Terre importera peu.

Théorie: la vie sur Terre, un phénomène inévitable ?

L'apparition de la vie sur Terre semble avoir dû faire face à tant d'obstacles, le choix des bons ingrédients, par exemple, et leur arrangement en entités vivantes (tout en étant bombardés par les météorites), que les scientifiques ont souvent la sensation d'être obligé de la considérer comme quasiment miraculeuse. Mais désormais, deux chercheurs américains suggèrent au contraire qu'elle pourrait avoir été inéluctable.

Le biologiste Harold Morowitz de l'université de Fairfax en Virginie et le physicien Eric Smith de l'institut de Santa Fe au Nouveau Mexique prétendent que la vie a été la conséquence obligée de l'accumulation d'énergie par les processus géologiques de la Terre primordiale. La vie a surgi de cet environnement, selon eux, de la même manière que la foudre soulage l'accumulation des charges électriques dans les nuages sombres. En d'autres termes, disent-ils, l'environnement géologique "a contraint la vie à exister".

Ce point de vue implique non seulement que la vie devait émerger sur la Terre, mais que la même chose devrait se produire sur n'importe quelle planète similaire. L'objectif final de Smith et Morowitz est de décrire les premières étapes de l'origine de la vie en se basant sur les seules lois de la physique et de la chimie.

Un métabolisme inversé

Les chercheurs admettent qu'ils ne possèdent pas encore les outils théoriques pour consolider leurs arguments, ou pour montrer quelle forme cette "vie inévitable" devait prendre. Mais, selon eux, elle a probablement utilisé les mêmes processus chimiques qui dirigent actuellement notre propre métabolisme - mais à l'envers.

Une des sources d'énergies géologiques aurait été constituée par les éléments appelés les polyphosphates, produits des processus volcaniques. Ce sont les molécules "piles", semblables à celles qui génèrent l'énergie des cellules vivantes actuelles. Une autre source aurait été les molécules d'hydrogène, qui étaient probablement abondantes dans l'atmosphère primordiale, bien qu'elles en soient pratiquement absentes aujourd'hui. De l'hydrogène aurait été produit, par exemple, par des réactions entre l'eau de mer et du fer dissous. Des réactions génératrices d'énergie entre l'hydrogène et le gaz carbonique expulsé dans l'atmosphère par les volcans, ont pu produire des molécules organiques complexes, précurseurs des systèmes vivants.

Dans notre métabolisme, une série de réactions biochimiques appelées le cycle du citrate (ou de Krebs) décompose les composés organiques des aliments en gaz carbonique. Horowitz et Smith suggèrent que les réservoirs d'énergie de la jeune Terre pourraient avoir entraîné un cycle de Krebs inversé, qui aurait engendré les briques de la vie tout en soulageant la "pression énergétique" de l'environnement. Par la suite ces processus se seraient encapsulés dans les cellules, rendant les flux d'énergie plus efficaces.

Une chimie adéquate

Selon Michael Russell, spécialiste en recherche sur les origines de la vie au CalTech à Pasadena, l'idée des chercheurs est "édifiante et source d'inspiration". La vie, convient-il, est "un système chimique qui draine et dissipe l'énergie chimique".

Russell avait utilisé des idées analogues pour dire que "la vie devrait surgir de la même manière sur toute planète rocheuse, ensoleillée et humide". Pour lui, les endroits propices à son apparition sont les petits volcans sous-marins, là où les ingrédients et les conditions sont "réglés" juste comme il faut pour que des machines chimiques énergétiques se développent.

Les processus biochimiques des organismes vivants sont fortement structurés. Les scientifiques sont depuis longtemps perplexes devant le fait que de tels systèmes puissent venir spontanément à la vie, alors que la seconde loi de la thermodynamique indique que l'univers dans son ensemble produit un désordre croissant.

La réponse, grossièrement, est que des groupes locaux ordonnés se forment aux dépens d'une augmentation du désordre dans leur environnement. Horowitz et Smith pensent qu'un tel ordre apparaît parce que c'est le meilleur "paratonnerre" pour décharger l'énergie excédentaire.

Ainsi, disent-ils, en dépit de plusieurs extinctions massives tout au long des temps géologiques, chacune d'entre elle ayant pratiquement éliminé toute entité vivante, la vie elle-même n'a jamais été menacée de disparition. Ceci parce qu'une Terre avec la vie est toujours plus stable qu'une Terre sans. Les chercheurs appellent ce processus un "effondrement vers la vie", qui selon eux est aussi inévitable que l'apparition des flocons de neige dans un air froid et humide.

|

|